Un modèle de sécurité qui s’adapte à l’évolution du réseau

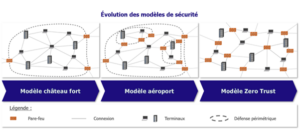

Dans un contexte où la donnée devient l’une des ressources les plus précieuses, il est aujourd’hui nécessaire pour les entreprises et les organismes mondiaux d’adapter la manière de sécuriser les systèmes d’information aux contraintes que représentent les menaces externes et internes. Pour pallier cette éventualité, les modèles de sécurité réseau évoluent. Le modèle traditionnel dit château fort s’est amélioré au fil du temps pour laisser aujourd’hui la place à un modèle de contrôle systématique appelé modèle Zero Trust. Pour mettre en place ce dernier, des architectures et des outils de sécurité réseau ont été développés.

Du modèle château fort au modèle Zero Trust en passant par le modèle aéroport

Le modèle château fort est historiquement le premier modèle de sécurité réseau. Ce modèle permet de contrôler chaque flux entrant ou sortant du réseau d’une entreprise grâce à des équipements de sécurité placés de manière périmétrique : des pare-feux, logiciel ou matériel permettant d’appliquer les règles de sécurité réseau de l’entreprise, des proxys inverses, serveurs placés en amont des serveurs web et qui interceptent les requêtes issues de clients, des zones démilitarisées ou DeMilitarized Zones (DMZ), réseaux d’ordinateurs servant de zones tampon entre deux réseaux, etc. Avec le temps, cette représentation est devenue obsolète en raison de l’ouverture vers l’extérieur avec le Cloud, ensemble des solutions de stockage distant. Les ressources commençant à être réparties entre plusieurs fournisseurs Cloud, il a fallu revoir la manière dont la sécurisation du système d’information était effectuée. Si le nombre d’interactions avec des réseaux externes croît, alors la possibilité qu’une menace pénètre le château fort croît également.

La possibilité d’une intrusion au sein du système a conduit à revoir le modèle château fort pour le faire évoluer vers le modèle aéroport. Il est important de préciser que les raisons de cette adaptation sont très bien détaillées dans l’article d’un collaborateur Wavestone sur l’évolution du modèle de sécurité : du château fort à l’aéroport. Comme expliqué dans cet article, ce modèle a pour objectif d’effectuer des contrôles plus poussés à proximité d’une zone sensible. De plus, il tient compte de l’aspect préventif et adaptatif de la sécurité. En effet, ce modèle intègre la détection et la réaction de manière rapide et adaptée à de probables menaces.

Mais aujourd’hui, ce n’est plus suffisant. L’augmentation de la complexité des applications, des systèmes informatiques et des infrastructures obligent des flux potentiellement critiques à transiter par internet. Cela conduit à remettre en question la légitimité de chaque flux à tout instant, en toute zone, qu’importe son origine. Le modèle Zero Trust propose une vision absolue de la sécurité, remettant l’utilisateur au centre avec la garantie qu’aucune confiance ne lui sera accordée. Cela signifie que le contrôle pour l’accès à une ressource doit être systématique, chaque fois qu’une entité en exprime le besoin, qu’importe son origine et même s’il s’agit d’un utilisateur interne. Seules les autorisations strictement nécessaires pour garantir l’accès à cette ressource doivent être accordées. L’identité et l’authentification sont au centre, au même titre que les moyens de détection et de contrôle1. C’est pour promouvoir et prioriser les étapes d’adoption d’un modèle sans confiance que l’architecture Secure Access Service edge (SASe, littéralement Accès Sécurisé en bordure de Service) a été proposée par Gartner.

Les promesses de l’architecture SASe

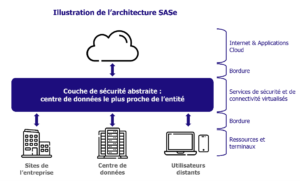

Les nouvelles façons de travailler remettent également en question la notion « périmétrique » de l’espace de travail : les collaborateurs d’une entreprise doivent pouvoir se connecter de n’importe où, avec n’importe quel appareil, et depuis n’importe quel réseau.

Traditionnellement, lorsqu’un utilisateur doit travailler à distance, il se connecte au réseau interne de l’entreprise via un Réseau Privé Virtuel (VPN pour Virtual Private Network). Il s’agit d’une connexion sécurisée et chiffrée entre deux réseaux ou entre un utilisateur et un réseau. Une fois connecté grâce à ce VPN, l’utilisateur est virtuellement à l’intérieur du réseau de l’entreprise et est protégé par le système de défense périmétrique.

Ce fonctionnement est efficace si l’utilisateur utilise majoritairement des applications internes à l’entreprise : son trafic effectue un aller-retour via le tunnel VPN supporté par internet entre l’endroit depuis lequel il travaille et le réseau de son entreprise. Cependant, lorsqu’il a besoin d’accéder à internet, son trafic passe par le VPN et sort sur internet via un point de sortie de l’entreprise, à travers des équipements dédiés : pare-feu, proxy (serveur intermédiaire entre le réseau de l’entreprise et internet), etc. Ceci permet la sécurisation des échanges. Le trafic effectue alors un premier trajet vers l’entreprise via le VPN, puis un aller-retour entre l’entreprise et internet, avant de revenir à l’utilisateur via son tunnel VPN. Cela provoque une latence, qui n’est pas encore nécessairement handicapante car le besoin d’accéder à internet reste limité par rapport à l’usage du réseau interne.

Mais avec l’évolution des infrastructures réseau et l’essor de l’informatique en nuage, de nombreuses applications auxquelles l’utilisateur doit accéder sont désormais hébergées sur internet. La proportion du trafic vers le réseau interne de l’entreprise diminue et la proportion du trafic vers internet augmente jusqu’à devenir majoritaire. En utilisant un VPN et l’accès à internet via le point de sortie sécurisé de l’entreprise, l’utilisateur rencontre désormais une latence pour effectuer la plupart de ses activités. De plus, tous ses collaborateurs sont dans le même cas : même s’ils ne sont pas tous à distance, ils accèdent tous aux applications hébergées en Cloud en passant par la sortie sécurisée de l’entreprise qui devient alors un goulot d’étranglement du trafic. La qualité de leur environnement de travail est dégradée2.

Pour pallier le problème de latence et décharger ce goulot d’étranglement, l’utilisateur distant pourrait se connecter directement aux applications virtualisées via internet, si l’on pouvait assurer la sécurité des échanges sans passer par une instance de vérification physiquement interne à l’entreprise3.

L’architecture SASe propose d’accompagner cette évolution de l’espace de travail en faisant converger les notions d’accès au réseau et de sécurisation du trafic. Le but est d’éviter au trafic de devoir transiter par une instance de sécurisation centrale située dans le centre de données de l’entreprise. La solution est de virtualiser les services de sécurisation du trafic et de les mettre à disposition de l’utilisateur au plus proche de sa position réelle dans des centres de données répartis dans le monde. Ainsi lorsque l’utilisateur a besoin d’accéder à une application hébergée sur internet, sa connexion passe par le centre de données capable d’authentification et de sécurisation du trafic le plus proche, puis sort directement sur internet4.

La micro-segmentation, une solution vers le modèle Zero Trust

Avant le Cloud, les seuls flux contrôlés étaient les flux entre serveurs et utilisateurs. Cependant, avec la croissance de l’utilisation de fonctionnalités Cloud, il devient également important de sécuriser les flux entre serveurs. Dans ce contexte, une technique de sécurité réseau appelée micro-segmentation a vu le jour. Elle a pour objectif de cartographier le réseau, d’appliquer des politiques de sécurité adaptées et de vérifier que chaque politique soit respectée en tout point afin de contenir toute attaque dans une zone restreinte. Pour réaliser cela, la solution repose sur une architecture composée d’un orchestrateur et de points d’application. Le premier consolide les données, identifie les connexions actives et définit les règles de sécurité. Les seconds collectent les données et appliquent les règles de sécurité.5

Deux concepts essentiels à la micro-segmentation : granularité et dynamisme

Le choix de la localisation des points d’application permet de définir la granularité de la micro-segmentation. Il existe trois possibilités :

- Dans les composants du réseau tel que des commutateurs réseaux, qui permettent de créer des circuits virtuels, ou bien des routeurs, qui permettent de faire transiter des paquets de données d’un réseau à l’autre

- Dans la couche de l’hyperviseur, qui est un logiciel qui permet la gestion des machines virtuelles au sein d’une même machine physique

- Dans le système d’exploitation d’hôtes sous forme d’agent

Chaque localisation possède ses avantages et ses inconvénients qu’il faut évaluer afin de trouver la meilleure approche.

La granularité n’est pas le seul concept important à saisir. En effet, la micro-segmentation serait impraticable s’il était nécessaire de créer et maintenir les règles de sécurité manuellement. Pour éviter cela, la micro-segmentation doit-être dynamique. Ce concept englobe trois notions essentielles :

- Abstraction : il s’agit de l’expression des règles de sécurité en termes de concepts applicatif (web, application et base de données) et non de langage dit « réseau » (adresse IP, sous-réseau, …).

- Intelligence : il s’agit de la capacité à détecter instantanément des changements sur les applications ou les infrastructures puis de reconfigurer les règles de sécurité en conséquence.

- Automatisation : il s’agit du déploiement rapide des nouvelles règles de sécurité aux points d’application sans intervention humaine.5

Une technique avec trois approches différentes

La différence entre les localisations des points d’application conduit à trois approches différentes de micro-segmentation.

- Tout d’abord, l’approche réseau s’appuie sur des composants classiques : pare-feux, commutateurs, routeurs, etc. Elle consiste à obtenir une image du trafic réseau notamment grâce à l’utilisation de Switch Port Analyzer (SPAN) des commutateurs ou d’interfaces de programmation d’application (API) Cloud. Une API est une interface permettant la communication entre applications. Les règles de sécurité sont appliquées en poussant des politiques aux points de contrôle déjà existant (pare-feux). Cette solution présente l’avantage d’être bien connue par les équipes réseau et donc facile à adopter. Cependant, elle peut présenter des défauts de sécurité comparée aux autres approches et des contrôles sous-optimisés pour tous les flux entre serveurs.6

- La seconde approche est l’approche hyperviseur. Les points de contrôles sont déployés au sein de la couche hyperviseur à l’aide de logiciels adaptés. Cette approche nécessite de choisir une solution compatible avec l’hyperviseur en place sur les serveurs. Elle n’est adaptée ni aux réseaux dépendants de services Cloud, ni aux environnements bare-metal sans hyperviseur. Un serveur bare-metal est un serveur physique dédié à un unique client. Il s’agit d’une solution efficace pour les environnements d’hyperviseurs mais il est également possible de la déployer dans un environnement de conteneurs. Cela dépendra de la solution de conteneur et d’hyperviseur.7

- La dernière approche est l’approche agent. Les agents sont des logiciels qui sont déployés dans le système d’exploitation d’hôtes8 : serveurs, machines virtuelles, instances Cloud. Une instance Cloud est une infrastructure physique ou virtuelle puissante accessible à distance qui exécute des applications et stocke des informations9. L’avantage de cette solution est d’être adaptée à tout type d’environnement car indépendant de l’infrastructure et de l’hyperviseur. De plus, cette solution offre une très fine granularité. Cependant, il est très important de s’assurer que chaque agent soit bien maintenu à jour car un agent contaminé ne protège plus l’hôte et peut même attaquer les machines de la zone qui n’ont pas d’agent.6

Malgré leurs différences, les approches de la micro-segmentation permettent un contrôle accru de la majorité des flux au sein du réseau.

En conclusion

Même si les approches et les technologies évoluent, le modèle Zero Trust est encore loin d’être applicable aux réseaux actuels. Dans son adoption la plus poussée, la fusion de l’accès au réseau et de sa sécurisation nécessite une transformation profonde des entreprises et signifie fusionner les métiers du réseau et de la sécurité, qui sont historiquement séparés. Par ailleurs, ce modèle impose de fortes contraintes qui ne sont parfois pas nécessaires pour assurer correctement la sécurité du réseau d’une entreprise. A l’avenir, il y a de fortes chances que chaque entreprise améliore la sécurité de son réseau pour tendre vers ce modèle.

Cet article a été rédigé par Mathias MASSARD et Théo CUOQ

Bibliographie

[1] Les enjeux et les tendances de la sécurité du cloud – RiskInsight (riskinsight-wavestone.com)

[2] SASE: the digital business enabler for your workforce, Orange Cyberdefense

[3] 2021 Strategic Roadmap for SASE Convergence, Gartner

[4] What is SASE? Secure Access Service Edge, Forcepoint

[5] Illumio eBook, The Definitive Guide to Micro Segmentation 2017 08

[6] Micro-Segmentation_Architecture-Agent-v-Agentless.pdf (guardicore.com)

[7] Micro-segmentation: Everything you need to know | NordLayer