Le besoin de traitement des données informatiques n’avait jamais été aussi fort qu’aujourd’hui et nos ordinateurs n’ont jamais été aussi performants. Néanmoins, avec l’arrivée du Big Data, de l’IoT, du cloud computing ou de l’intelligence artificielle, notre envie d’accélérer et d’augmenter nos capacités de traitement soulèvent toujours autant d’enjeux. Plusieurs acteurs technologiques majeurs (Google, Microsoft, IBM, Intel…) et même états (USA, Chine…) se positionnent sur une technologie naissante : le Quantum computing. Cette innovation serait capable, non seulement d’augmenter considérablement la rapidité de traitement des données sur certaines opérations complexes pour un ordinateur classique, mais également de prédire et simuler certains processus naturels. Voyons à quoi correspond réellement cette technologie émergente.

What is quantum computing ?, Leo Kouwenhoven, Director at Microsoft Quantum Lab, 2018.

Une technologie naissante

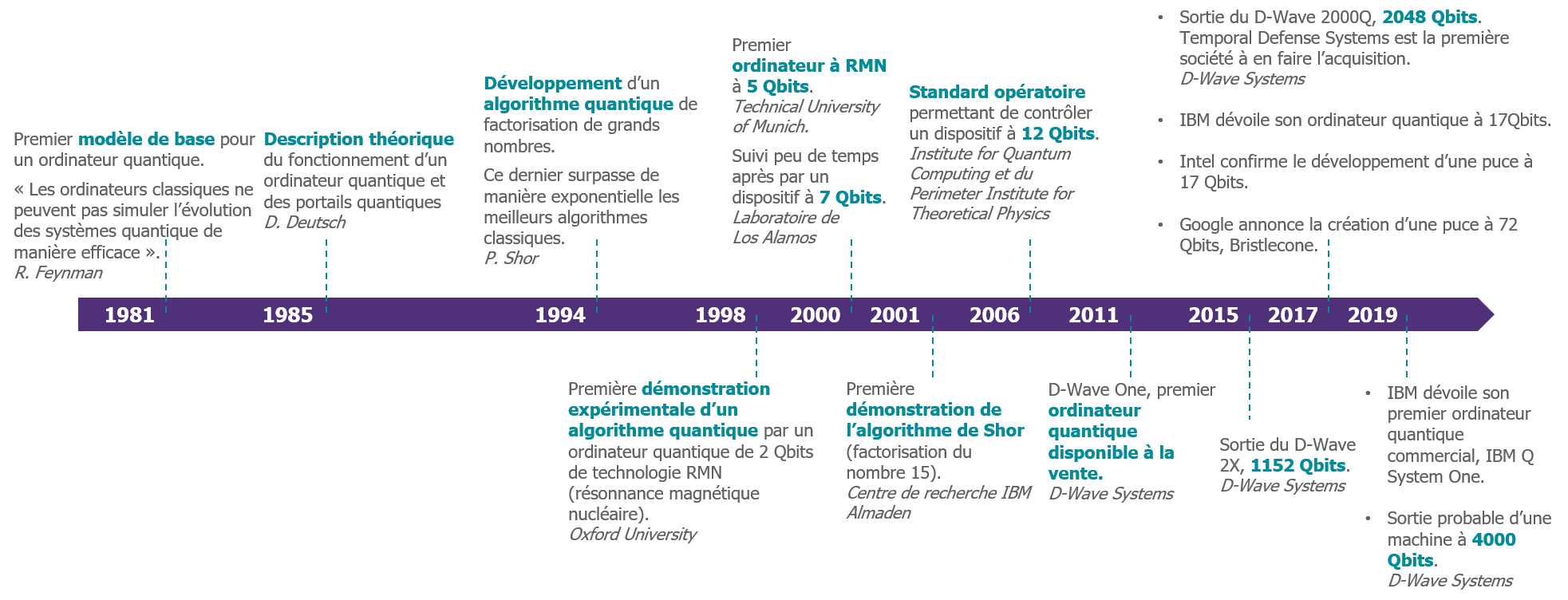

Le quantum computing a une histoire relativement jeune puisque qu’il a été théorisé dans les années 80. Il correspond à l’application de le théorie quantique, décrivant les interactions entre éléments à l’échelle de l’infiniment petit (i.e. comment les atomes et autres particules plus petites interagissent entre eux), appliqué au domaine du calcul informatique. Par conséquent, le quantum computing correspond à l’utilisation de particules à l’échelle quantique (atomes, électrons, photons), en vue d’améliorer les performances de nos dispositifs informatiques.

En effet, le nombre de données à traiter et la besoin d’immédiateté de ces traitements ne cessent d’augmenter depuis les années 90. Nous outils de calcul sont améliorer en conséquent. Ce phénomène est illustré par la loi de Moore, cofondateur d’Intel, qui stipule que tous les 18 mois, le nombre de transistors sur un microprocesseur est doublé. A ce rythme, d’ici les années 2030 la taille de ces transistors atteindra la taille des atomes, représentant une barrière forte à la progression de la loi de Moore. En 2019, les premiers transistors gravés en 5nm devraient apparaître, correspondant à une vingtaine d’atomes de silicium.

Une seconde raison du développement de quantum computing résulte dans le manque de performances de nos ordinateurs actuels à résoudre des problèmes de combinatoire (configurations de collections finies d’objets et les dénombrements) ou de modélisation de l’évolution du vivant.

Bien qu’il soit aujourd’hui difficile d’envisager quel serait le champs des possibles une fois cette technologie maîtrisée, de nombreuses applications possibles sont recensées. Elles devraient avoir un impact sur de nombreux secteurs (santé, énergie et chimie, finance, cybersécurité…). Richard Feynman, prix Nobel de physique 1965 pour ses travaux sur l’électrodynamique quantique et un des pères fondateurs du quantum computing faisait d’ailleurs déjà ce constat : « Si vous voulez faire une simulation de la nature, vous feriez mieux de faire de la mécanique quantique… ».

S’inspirer du vivant afin de créer un modèle plus performant

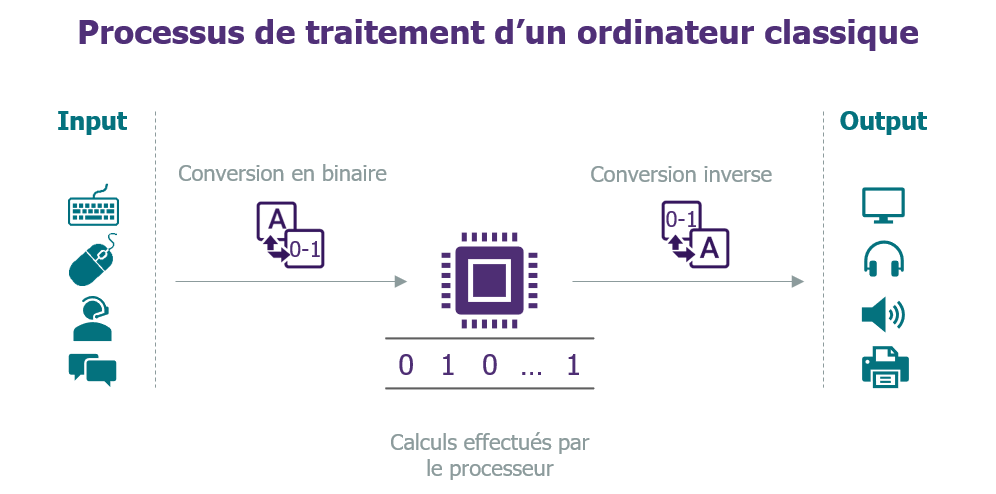

Pour percevoir le fonctionnement d’un ordinateur quantique, il est nécessaire dans un premier lieu de bien comprendre le fonctionnement des ordinateurs que nous utilisons actuellement. Un ordinateur classique, permet le traitement de l’information sous forme de bits. Un bit est une unité d’information correspondant à deux digit, 0 ou 1. Au sein du processeur, un bit correspond physiquement à un état électrique pouvant prendre uniquement deux valeurs au sein d’un transistor. Par conséquent chaque information, pour être traitée par l’ordinateur, doit être numérisée (c’est-à-dire traduite sous la forme d’une chaîne de 0 et de 1). Ce processus s’effectue de manière presque instantanée à nos yeux.

Pour percevoir le fonctionnement d’un ordinateur quantique, il est nécessaire dans un premier lieu de bien comprendre le fonctionnement des ordinateurs que nous utilisons actuellement. Un ordinateur classique, permet le traitement de l’information sous forme de bits. Un bit est une unité d’information correspondant à deux digit, 0 ou 1. Au sein du processeur, un bit correspond physiquement à un état électrique pouvant prendre uniquement deux valeurs au sein d’un transistor. Par conséquent chaque information, pour être traitée par l’ordinateur, doit être numérisée (c’est-à-dire traduite sous la forme d’une chaîne de 0 et de 1). Ce processus s’effectue de manière presque instantanée à nos yeux.

Un ordinateur quantique fonctionne grâce à de l’information stockée sous forme quantique. Les bits ici ont une certaine probabilité d’être un 0 et une autre probabilité d’être un 1. C’est la superposition. Jusqu’à ce qu’un bit soit mesuré son état est indéfini. Le bit est alors appelé quantum bit ou qubit (quantum bit). Sa représentation physique est alors un système constitué d’une ou plusieurs particules (atomes, électrons…) ayant des propriétés quantiques.

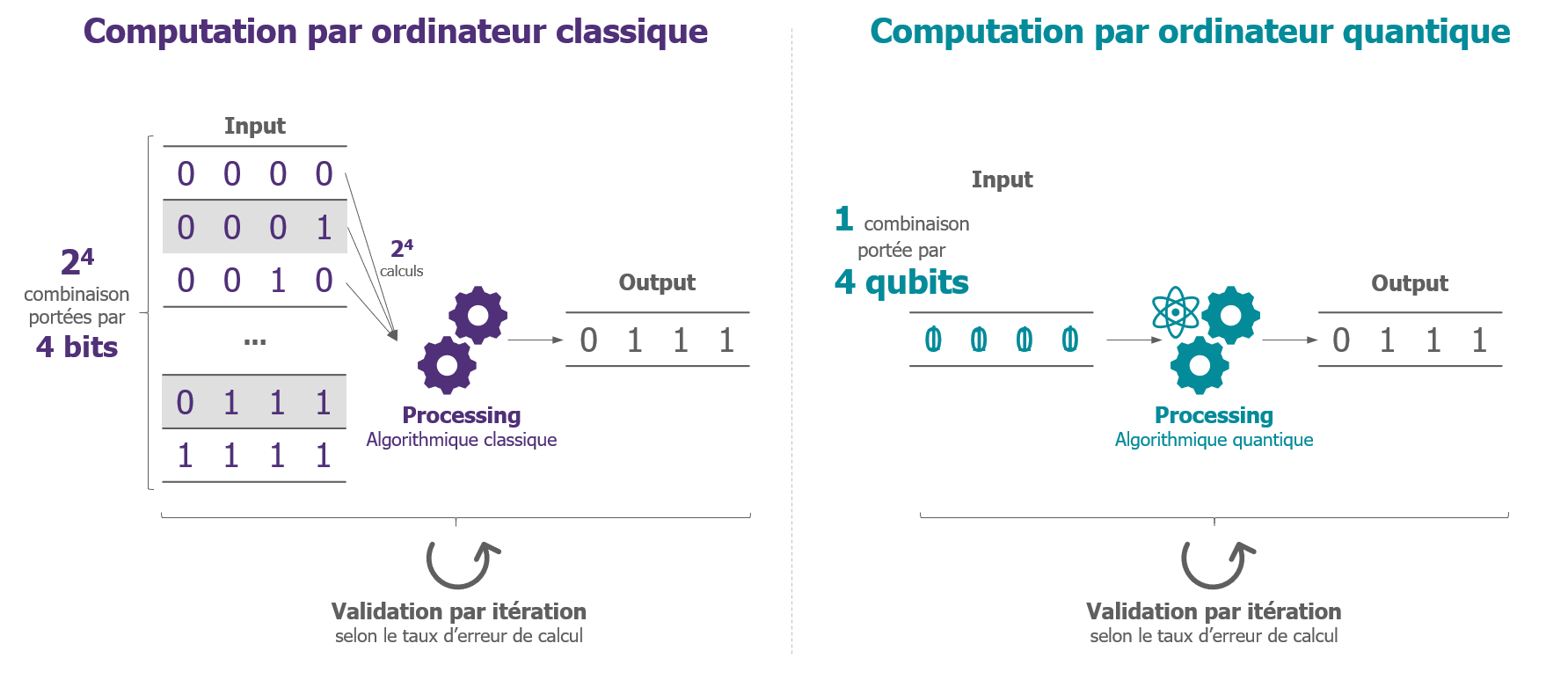

Un ordinateur quantique peut donc effectuer des opérations sur des qubits en état de superposition. En faisant varier la probabilité associée au 0 et celle associée au 1 du bit classique, ce nouveau type d’ordinateur permet d’effectuer une opération simultanément sur un ensemble de valeurs stockées dans un seul qubits.

Vous trouverez une vidéo explicative sur un exemple concret ici.

L’ordinateur quantique utilise également une seconde propriété de la théorie quantique, l’intrication quantique, ou enchevêtrement quantique. En physique quantique, deux particules peuvent être intriquées : leurs états sont alors liés et leurs changements sont alors répercutés de façon instantanée. Lors d’un calcul informatique, un qubit va être relié à d’autres qubits lorsque qu’on va leur appliquer des portes logiques (composants unitaires permettant les calculs sur les qubits). Les qubits vont ainsi se retrouver intriqués. Cette propriété d’intrication oblige à repenser la gestion des données au sein d’un processeur quantique. Dans un processeur traditionnel les bits de données circulent au travers des portes logiques et sont dupliqués pour faire des calculs et des lecture/écriture (dans les registres, ou mémoires…). Au contraire, dans un processeurs quantiques, les qubits sont fixes, ce sont les portes logiques qui agissent sur ces qubits. Par ailleurs, on ne peut les dupliquer.

Enfin, on ne peut lire le résultat uniquement à la fin d’un calcul quantique. Il n’est pas possible de lire un résultat intermédiaire pour faire un test (if .. then) et poursuivre le calcul sur cette donnée. En effet, le fait de lire le résultat va rompre la superposition d’état et donc interrompre le calcul parallèle sur l’ensemble des états en superposition. C’est une conséquence du principe d’incertitude de Heinsenberg.

Pour toutes ces raisons, un ordinateur quantique est systématiquement doté d’un processeur traditionnel qui a la charge de piloter le processeur quantique pour initialiser les qubits, orchestrer les opérations quantiques, puis lire et interpréter le résultat. Ce résultat peut être faux car il s’agit d’une mesure d’un fonction statistique (un dé pipé ne tombe pas toujours sur le 6). On peut donc être amené à répéter plusieurs fois un calcul pour minimiser le risque d’erreur.

Un ordinateur quantique tire sa puissance de plusieurs composantes :

- Le nombre de qubits: cela détermine la capacité de parallélisme : un ordinateur de n qubits peut effectuer la même opération simultanément sur les 2^n combinaisons possible en entrée.

- Le taux d’erreur: plus il sera faible, moins il sera nécessaire de réitérer une opération pour s’assurer de sa fiabilité.

- Le temps de cohérence: durée pendant laquelle les qubits reste en état de superposition. Plus il est long, plus l’algorithme quantique (enchainement successif de portes logiques) avant d’arriver au résultat peut être complexe.

Dans cet article, Charles Verdon, Data Innovation Strategist chez Microsoft, vous présente un état de l’art du développement de cette technologie au sein d’IBM, Google, Intel et bien entendu Microsoft.

Au-delà du design matériel de l’ordinateur quantique, le socle logiciel doit aussi s’adapter (notamment les langages de programmation et compilateur), car les ordinateurs quantiques ne sont pas optimisés pour les mêmes opérations que les ordinateurs classiques. De nombreuses plateformes logicielles adaptées au quantum computing sont déjà disponibles. Elles peuvent être utilisées sur un ordinateur classique simulant le fonctionnement d’un ordinateur quantique (sans bénéficier néanmoins de l’efficacité du temps de traitement). Ces plateformes se différencient souvent par la nature du traitement cible : cryptographie, biochimie, finance, modélisation physique, intelligence artificielle…

Des cas d’usages très spécifiques mais sur des domaines d’applications très variés

Du fait des caractéristiques vues ci-dessus du calcul quantique, celui est applicables à certain problème assez spécifiques nécessitant d’effectuer le même calcul sur un grande combinatoire en entrée.

- Cryptographie – La cryptographie moderne à base de clés asymétriques est le fondement de la plupart des communication chiffrée (système PKI). Mais, l’algorithme de Shor, permettant la factorisation de grand nombre premier, transforme ce problème complexe pour un ordinateur classique en un problème simple pour un ordinateur quantique. Heureusement, il n’existe pas encore d’ordinateur quantique avec suffisamment de qubits pour casser ce chiffrement. Mais, il sera donc nécessaire de réinventer les méthodes de chiffrement de nos communications numériques, avant qu’un ordinateur quantique assez puissant existe.

- Chimie moléculaire – Simulation du fonctionnement et construction de molécules :

Les composés chimiques nécessite de grande puissance de calcul pour modéliser l’ensemble des interactions entre les atomes qui les composent. Avec l’informatique quantique, il sera alors possible de simuler et de prévoir le développement de ces molécules et ainsi construire de nouveaux composés chimiques (produits pharmaceutiques, engrais…). - Intelligence artificielle – Accélérer la phase d’apprentissage des systèmes basés sur du machine learning :

L’IA est l’un des secteurs de recherche les plus actifs. Que ce soit du point de vue de l’algorithmique ou des processeurs quantiques, l’informatique quantique pourra accélérer la phase d’apprentissage des réseaux neuronaux et rendre les algorithmes de traitement plus rapides. Cela permettra de développer des réseaux de neurones plus complexe et donc potentiellement plus performant, sensible voire intelligent - Bien d’autres encore…

De nombreux cas d’usages ne peuvent pas être conçus voire même imaginer aujourd’hui. Certains, ne deviendront apparent qu’une fois la technologie mature et accessible à grande échelle.

Une technologie toujours en construction

Les scientifiques et chercheurs ont certes déjà réussi à créer des premiers ordinateurs quantiques et aujourd’hui plusieurs exemples de dispositifs existent : les circuits photoniques, les supraconducteurs électroniques ou encore les ions piégés. Néanmoins, aucun standard ne s’est encore imposé et nous sommes encore dans une période d’expérimentation et de recherche. Par conséquent, il est peu probable que la création de dispositifs à grande échelle et la généralisation de cette technologie pour le grand public surviennent dans les années proches.

En effet, le quantum computing nécessite encore des condition de laboratoires (refroidissement à très basse température, utilisation de laser ou de supraconducteurs) et les algorithmes quantiques existants ne répondent qu’à une certaine typologie de problèmes. Cependant, à l’image des transistors inventés à la fin des années 40, dont l’évolution à l’époque était peu prévisible et qui sont aujourd’hui omniprésents au sein de nos appareils informatiques, les ordinateurs quantiques devraient certainement avoir un impact considérable sur nos sociétés.

Par ailleurs, les modèles « Cloud » permettent aujourd’hui de faciliter l’accessibilité à certaines technologies. Ainsi IBM propose déjà un service Cloud pour « consommer » leurs ordinateurs quantiques en expérimentation.

Si l’informatique quantique semble désormais une évolution quasi inéluctable, quoique long terme, elle pourrait se voir concurrencer par d’autres technologies émergentes, comme le neuromorphic computing. Ce dernier vise à créer des circuits électroniques imitant le fonctionnement des neurones humains, et proposer ainsi une autre alternative pour des traitements particuliers et gourmand en calcul, comme l’intelligence artificielle. Le risque pour l’informatique quantique est donc de voir drainer les investissements vers d’autres technologies et ainsi retarder son développement et son arrivée à un stade commercial.

Pour aller plus loin :

Tester vos connaissances sur le quantum computing ici.

Etat des lieux de la cryptographie post-quantique, David Renty, RiskInsight, 2018,

https://www.riskinsight-wavestone.com/2018/08/cryptographie-post-quantique/

The Next Decade in Quantum Computing—and How to Play, Philipp Gerbert

L’ebook pour comprendre l’informatique quantique, Olivier Ezratty, 2018,

https://www.oezratty.net/wordpress/2018/ebook-pour-comprendre-informatique-quantiqu..

Excellente article de vulgarisation

Thanks