L’intelligence artificielle n’est pas simplement une tendance éphémère, créant à la fois la sensation et la crainte. Derrière la promesse incroyable de rendre la machine raisonneuse, logique, intelligente, voire même dotée d’une conscience, réside des années de recherche. Cet article vous propose un décryptage du fonctionnement de ce que l’on appelle l’IA afin de vous réconcilier avec ce terme trop souvent décrié.

Comment définir l’intelligence artificielle ?

Le terme d’intelligence artificielle (IA) reste très flou tant la diversité des définitions qui lui sont attribuées est grande. Pour certains ce terme illustre la capacité qu’ont des programmes à raisonner ou agir comme des êtres humains. Pour d’autres c’est la capacité de machines à résoudre des problèmes cognitifs liés aux capacités humaines, en acquérant des connaissances sur leur environnement. Ces dernières définitions peuvent être combinées, modifiées, réarrangées, de telle sorte que bien d’autres définitions existent en réalité.

Ce que nous pouvons remarquer c’est que l’intelligence artificielle marque un changement dans notre façon d’interagir avec les machines et dans nos attentes vis-à-vis d’elles. Raisonnement, intention et même intelligence font aujourd’hui débat, mais pourraient être présents à différents degrés au sein des machines qui nous entourent.

Naissance et développement

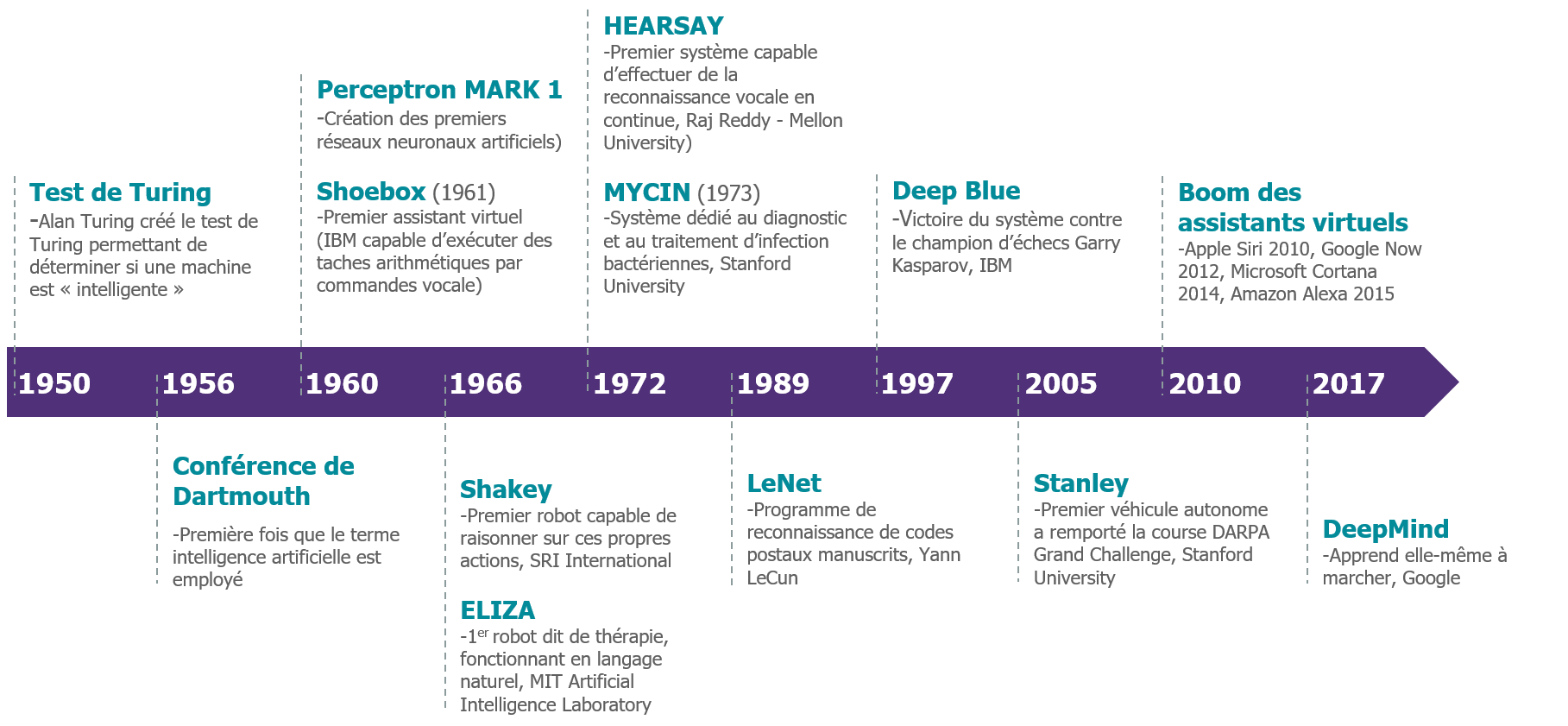

Malgré l’effervescence actuelle, l’intelligence artificielle n’est pas véritablement une nouveauté. C’est un thème de recherche datant de plus d’un demi-siècle et qui n’a cessé d’évoluer. En effet, la première mention de l’intelligence artificielle date de 1956 et de la conférence de Dartmouth, durant lequel John McCarthy et une dizaine d’autres savants devaient établir les bases et le cadre de l’intelligence artificielle ainsi que les possibles axes de travail à venir.

A l’époque, trois champs de recherche connexes se distinguent : la cybernétique, les théories d’automation et le traitement de l’information complexe. McCarthy invente le terme d’intelligence artificielle afin d’unifier ces trois champs de recherche autour de l’intelligence artificielle comme nous la connaissons aujourd’hui. Au fil des années de nombreuses avancées technologiques ont vu le jour, jalonnant ainsi le développement de l’IA pour conduire à la situation d’effervescence dans laquelle sommes actuellement. On peut citer notamment Shoebox (1961) le premier assistant virtuel capable d’exécuter des taches arithmétiques par commandes vocale (IBM), ELIZA (1966) le premier robot dit de thérapie fonctionnant en langage naturel (MIT Artificial Intelligence Laboratory, vous pouvez l’essayer ici), LeNet (1989) un programme de reconnaissance de codes postaux manuscrits conçu par Yann LeCun) ou encore la société DeepMind (2017) qui a réussi à développer une IA capable d’apprendre à marcher.

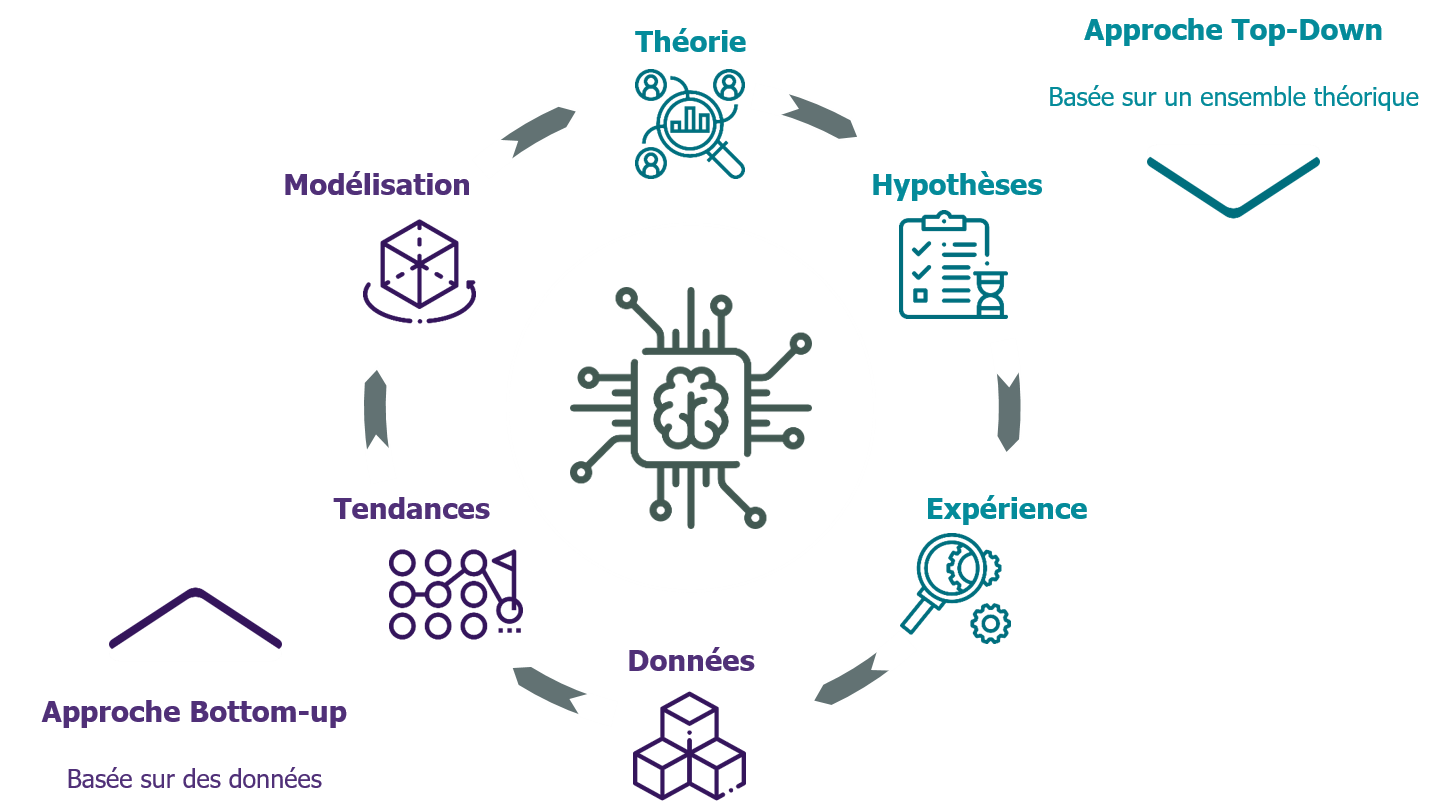

Au fil des années, deux grandes écoles avec des représentations opposées de l’IA, s’affrontent avec chacune leur moment d’apogée. La première consiste à une approche descendante, la cognition est traitée comme un phénomène de haut niveau en excluant les détails de bas niveau. Elle se base sur l’analyse des processus de réflexion et de décision humains. Concrètement, pour décrire une situation un ensemble de règles et de symboles sont stockés dans la mémoire du programme et permettent ainsi une prise de décision de la part de la machine. On appelle cela l’IA top-down ou IA symbolique. A l’inverse l’IA bottom-up, connexionniste, a une approche ascendante où l’on présente un ensemble de données qui vont être traitées par un processus de décision, un réseau de neurones le plus souvent.

L’approche symbolique a eu le vent en poupe dans les années 70 mais les récents développements technologiques (puissance des processeurs et des algorithmes, big data, cloud et décentralisation…) ont favorisé le succès de l’IA ascendante. Nous allons par conséquent nous concentrer sur ce champ de recherche.

Inspiré de Guillaume Dumas, Institut Pasteur, 2018

Différents stades de maturité

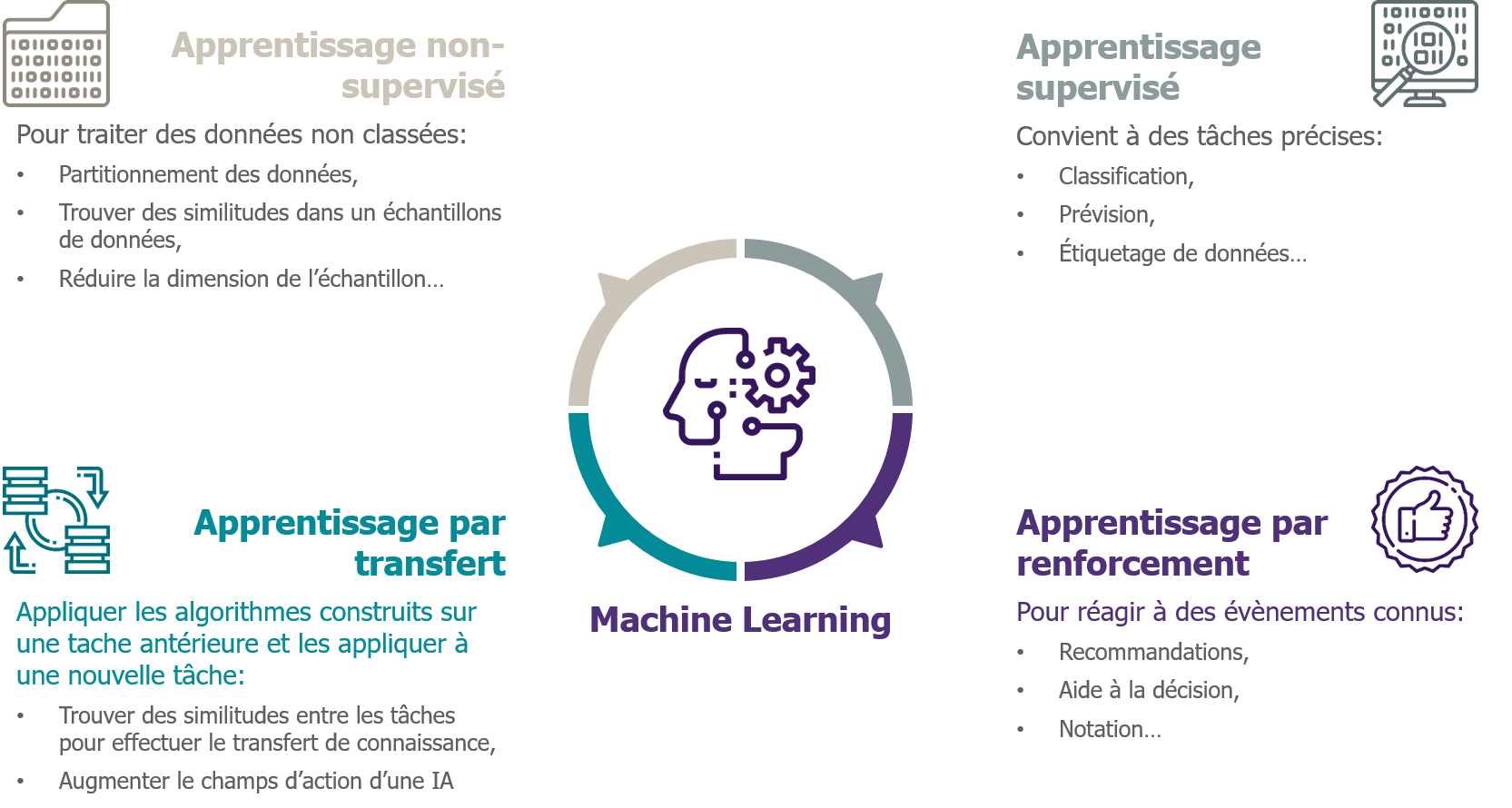

Comme illustré plus haut le fonctionnement de l’IA bottom-up part d’une base de données descriptive à laquelle on ajoute un processus neuronal de décision. Le sous ensemble le plus en vue de nos jours attrait au champ d’étude du machine learning au sein duquel quatre catégories d’apprentissage sont mises en lumière : l’apprentissage supervisé (les données sont classées), l’apprentissage non supervisé (les données sont non-classées), l’apprentissage par renforcement (l’environnement procure à la machine un feedback positif ou négatif sur l’action réalisée) et enfin l’apprentissage par transfert (une IA développée pour un précédant usage et testée et enrichie sur un nouvel usage). L’utilisation de ces différentes techniques dépend de l’usage ciblé, mais également de la précision de la réponse ainsi que du « temps » d’apprentissage nécessaire.

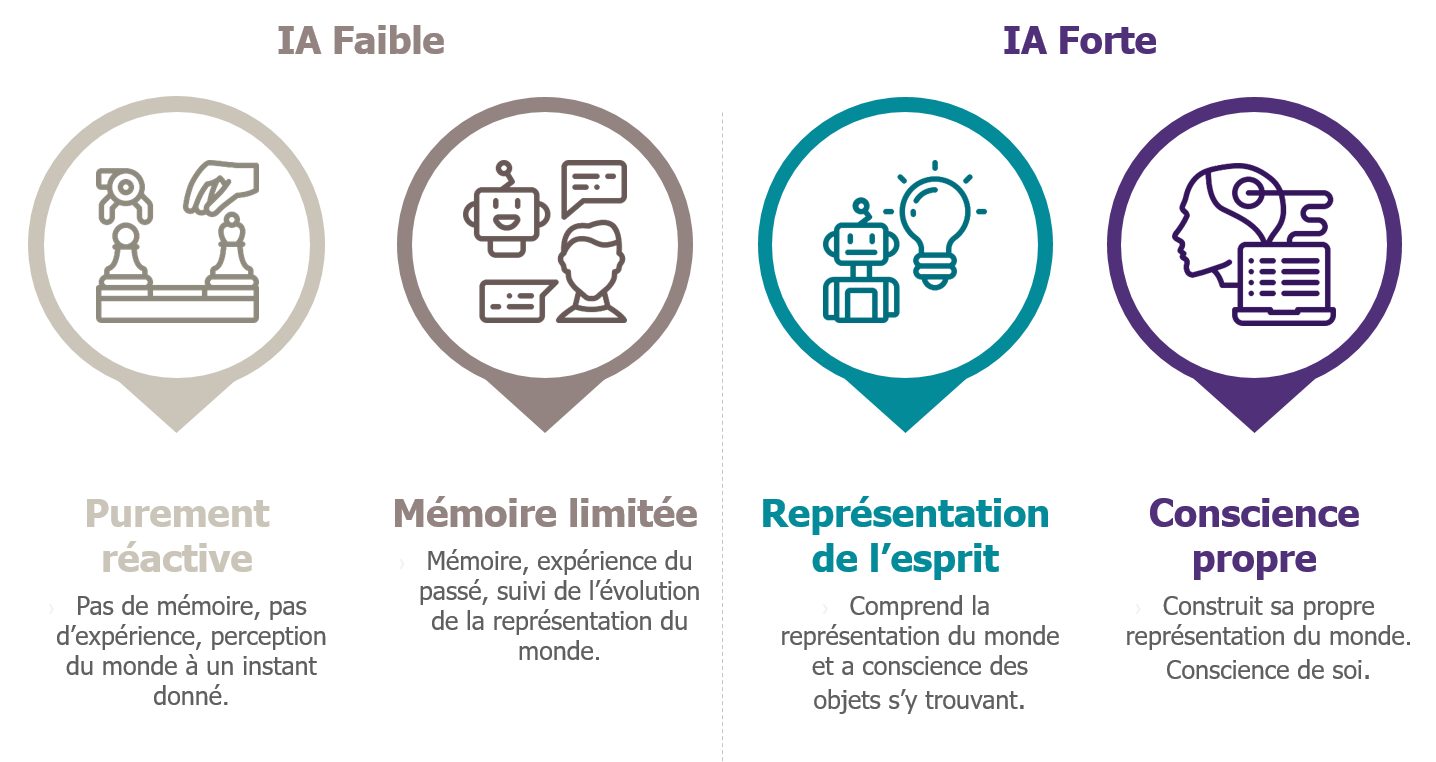

Au sein de ce différents type d’IA, il est possible de distinguer quatre stades de maturité :

- Type I – Purement réactive :

C’est la forme la plus basique. Pas de mémoire, pas d’expérience du passé qui pourraient affecter une décision, elles sont le plus souvent spécialisées sur un domaine (ex : IBM Deep Blue, Google AlphaGo).

- Type II – : Mémoire limitée :

Elles sont capables de prendre en compte des données et expériences passées pour les ajouter à leurs représentations. En ce sens elles créent dans une certaine mesure leurs propres décisions (ex : véhicule autonomes, chatbots, assistants personnels digitaux).

- Type III – Représentation de l’esprit :

Cette étape marque un point de rupture avec les deux précédentes. Les IA sont ici capables de comprendre des pensées et des émotions qui affectent les comportements humains, d’appréhender nos représentations du monde (ex : C-3PO dans Star Wars).

- Type IV – Conscience propre :

Pour aller plus loin nous pouvons que les IA pourraient avoir leurs propres représentations et développer ainsi leurs propres émotions et croyances (ex : Eva dans Ex Machina). Elles pourraient même être capable de prédire les actions des humaines.

Il est possible de réduire ces catégories à deux unités en utilisant les termes IA faible et IA forte. L’IA faible se concentre sur la réalisation d’une tâche précise, en associant des données et des techniques afin d’arriver à un processus de décision (souvent extrêmement rapide). C’est la forme la plus répandue actuellement. L’IA forte a contrario correspond aux programmes dotés d’une conscience, d’une sensibilité, et qui seraient capables de comprendre et d’analyser leurs propres raisonnements. Aujourd’hui, il n’existe pas de programme ou de machine correspondant à cette catégorie. Il est même peu probable que ce type d’IA existe un jour.

Une singularité technologique préoccupante

Comme nous avons pu le percevoir dans cet article, l’IA n’est pas une notion passagère et éphémère. C’est une tendance ancrée qui devrait transformer nos sociétés de manière durable et profonde, à tel point que cela peut même nous effrayer. En effet, c’est bien cet aspect de singularité technologique, l’hypothèse selon laquelle l’IA en catalysant l’innovation technologique pourrait induire des changements imprévisibles sur nos sociétés, qui peut rendre perplexe de nos jours. D’autant plus que la plupart des algorithmes utilisés apparaissent comme des boites noires incompréhensibles dont le cheminement de réflexion nous échappe.

Néanmoins, comme l’énonce le cabinet Roland Berger, ces 20 dernières années nous avons vécu trois tendances d’innovation technologiques majeures : matérielle (avec IBM, Apple et Intel), logicielle (avec Microsoft en précurseur) et enfin mobile, principalement avec les smartphones (Apple). Ces technologies ont transformé nos sociétés et nos modes de vie, en les rendant plus mobiles, plus connectés, plus collaboratifs. L’IA, en tant que technologie de rupture, s’inscrit dans ce même processus en favorisant le développement de nouveaux champs technologiques (IoT, blockchain, big data, robotique…). Comme les précédentes technologies à usage général (électricité, technologies de l’information…), il est certain que l’IA affectera tous les secteurs d’activité et par conséquent nos vies de manières générales.

S’associer à l’IA pour accomplir l’irréalisable

A l’opposé de l’image destructrice qui lui est donnée par certains, l’IA est donc un outil qui doit nous permettre de faire des choses dont on ne serait pas capable autrement. A l’heure actuelle aucune forme d’IA n’a d’intention ou de conscience. Il est même très peu probable que cela arrive un jour. Par conséquent, c’est bien la représentation du monde que nous présentons aux algorithmes, sous forme de données, et les intentions des humains derrière ces programmes qui orientent les processus de décision. C’est notamment pour accompagner ces développements et éviter des dérives possibles, imaginées par Elon Musk ou Stephen Hawking , que des initiatives collaboratives comme IA for Good ou AI for Humanity voient le jour.

Nous terminerons par un message de Daniela Rus, directrice du laboratoire Computer Science and Artificial Intelligence au MIT, résumé ainsi : Plutôt que de craindre la destruction de nos emplois par l’IA, je crois que les personnes et les machines devraient travailler ensemble plutôt qu’être en compétition. Car la Machine et l’Homme peuvent être complémentaires, bénéficiant l’un et l’autre des atouts de chacun. Ensemble nous pouvons réaliser de bien plus grandes choses. EmTech MIT 2017, Machines are better when they team up, Novembre 2017.

Pour aller plus loin :

Cédric Villani : « L’intelligence artificielle, ce n’est pas intelligent« , France Culture, 2018

Yann LeCun : « La prochaine révolution de l’Intelligence artificielle« , ‘USI, 2018

Images par : Flaticon.com

Digital image processing, What is Image Enhancement and Image Restoration

In computer science, digital image processing is the use of a digital computer to process

digital images through an algorithm. As a subcategory or field of digital signal processing,

digital image processing has many advantages over analog image processing.